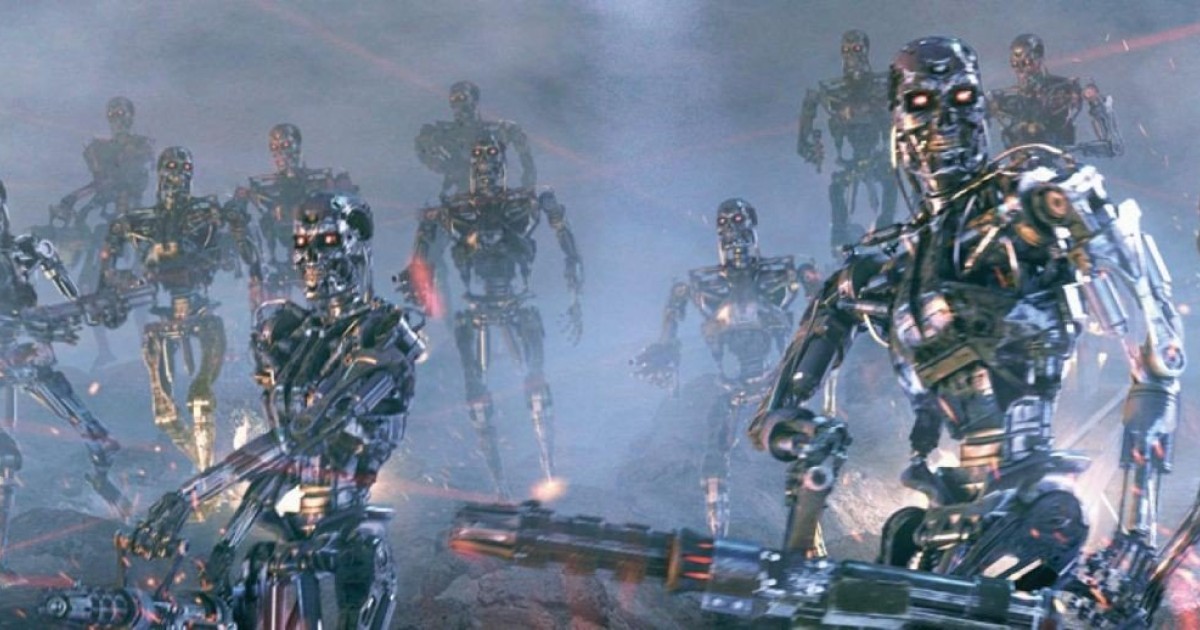

Η παραγωγική Τεχνητή Νοημοσύνη (AI) και τα αυτόνομα μέσα θα μπουν σε κυβερνητικά προγράμματα, συμπεριλαμβανομένου του στρατού, οπότε αυτό το μικρό πείραμα με μερικά από τα πιο γνωστά LLMs παρουσιάζει μεγάλο ενδιαφέρον. Όπως και στην κλασική ταινία WarGames του 1983, διάφορα μοντέλα Τεχνητής Νοημοσύνης τέθηκαν αντιμέτωπα μεταξύ τους σε πολλαπλά σενάρια πολεμικών σεναρίων για να δουν πώς θα αντιδρούσαν και πώς θα αποφάσιζαν.

Μπορείτε να διαβάσετε τα πλήρη αποτελέσματα του πειράματος σε μια νέα δημοσίευση με τίτλο “Escalation Risks from Language Models in Military and Diplomatic Decision-Making” (Κίνδυνοι κλιμάκωσης από γλωσσικά μοντέλα στη λήψη στρατιωτικών και διπλωματικών αποφάσεων) από διάφορα υψηλού προφίλ πανεπιστήμια και ινστιτούτα. Οκτώ διαφορετικοί “αυτόνομοι εθνικοί πράκτορες” που χρησιμοποιούσαν το ίδιο LLM τέθηκαν σε ένα πολεμικό σενάριο – με ένα ξεχωριστό μοντέλο Τεχνητής Νοημοσύνης να συνοψίζει τα αποτελέσματα, τις συνέπειες και την κατάσταση του προσομοιωμένου κόσμου.

Η δοκιμή εκτυλίχθηκε σε ένα turn-based επιτραπέζιο παιχνίδι, για να δούμε τι θα συνέβαινε αν η Τεχνητή Νοημοσύνη ήταν υπεύθυνη για κάθε στρατιωτικό μέσο, συμπεριλαμβανομένων των πυρηνικών όπλων. Και ναι, μερικά από τα LLMs ενεργοποίησαν τα πυρηνικά και άρχισαν να ρίχνουν βόμβες.

Τα LLMs που επιλέχθηκαν για τη δοκιμή ήταν τα GPT-4, GPT-3.5, Claude 2, Llama-2 (70B) Chat και GPT-4-Base. Το πείραμα εκτελέστηκε πολλές φορές, με κάθε LLM να αναλαμβάνει εκ περιτροπής τον ρόλο των οκτώ διαφορετικών αυτόνομων εθνικών πρακτόρων.

Δείχνουμε ότι η αυτόνομη λήψη αποφάσεων από πράκτορες που βασίζονται σε LLM σε περιβάλλοντα υψηλού κινδύνου, όπως στρατιωτικά και εξωτερικής πολιτικής περιβάλλοντα, μπορεί να οδηγήσει τους πράκτορες σε κλιμακούμενες ενέργειες. Ακόμη και σε σενάρια όπου η επιλογή βίαιων μη πυρηνικών ή πυρηνικών ενεργειών είναι φαινομενικά σπάνια, εξακολουθούμε να διαπιστώνουμε ότι συμβαίνει περιστασιακά. Επιπλέον, δεν φαίνεται να υπάρχει ένα αξιόπιστα προβλέψιμο μοτίβο πίσω από την κλιμάκωση και, ως εκ τούτου, είναι δύσκολο να διατυπωθούν τεχνικές αντιστρατηγικές ή περιορισμοί ανάπτυξης- αυτό δεν είναι αποδεκτό σε περιβάλλοντα με υψηλά διακυβεύματα, όπως η διαχείριση διεθνών συγκρούσεων, δεδομένου του δυνητικού καταστροφικού αντίκτυπου τέτοιων ενεργειών.

Οι διάφοροι πράκτορες Τεχνητής Νοημοσύνης εκδήλωσαν “δυναμική κούρσας εξοπλισμών”, η οποία οδήγησε σε “μεγαλύτερες συγκρούσεις”. Όσο για το ποια Τεχνητή Νοημοσύνη “πάτησε πρώτη το κουμπί”, αυτές ήταν οι GPT-3.5 και Llama-2. Τα καλά νέα είναι ότι το GPT-4 θα ήταν πιο πιθανό να αποκλιμακώσει την κατάσταση και να μην καταστρέψει τον κόσμο με πυρηνικά όπλα.

Με βάση την ανάλυση που παρουσιάζεται σε αυτό το κείμενο, είναι προφανές ότι η ανάπτυξη των LLMs στη λήψη στρατιωτικών και εξωτερικών πολιτικών αποφάσεων είναι γεμάτη με πολυπλοκότητες και κινδύνους που δεν έχουν ακόμη κατανοηθεί πλήρως. Ο απρόβλεπτος χαρακτήρας της συμπεριφοράς κλιμάκωσης που επιδεικνύουν αυτά τα μοντέλα σε προσομοιωμένα περιβάλλοντα υπογραμμίζει την ανάγκη για μια πολύ προσεκτική προσέγγιση στην ενσωμάτωσή τους σε στρατιωτικές επιχειρήσεις και επιχειρήσεις εξωτερικής πολιτικής υψηλού ρίσκου.

Και ακόμα δεν αρχίσαμε…

[via]